Algoritmer masseovervåger og diskriminerer udsatte grupper

Illustration: Ard Su/Amnesty International

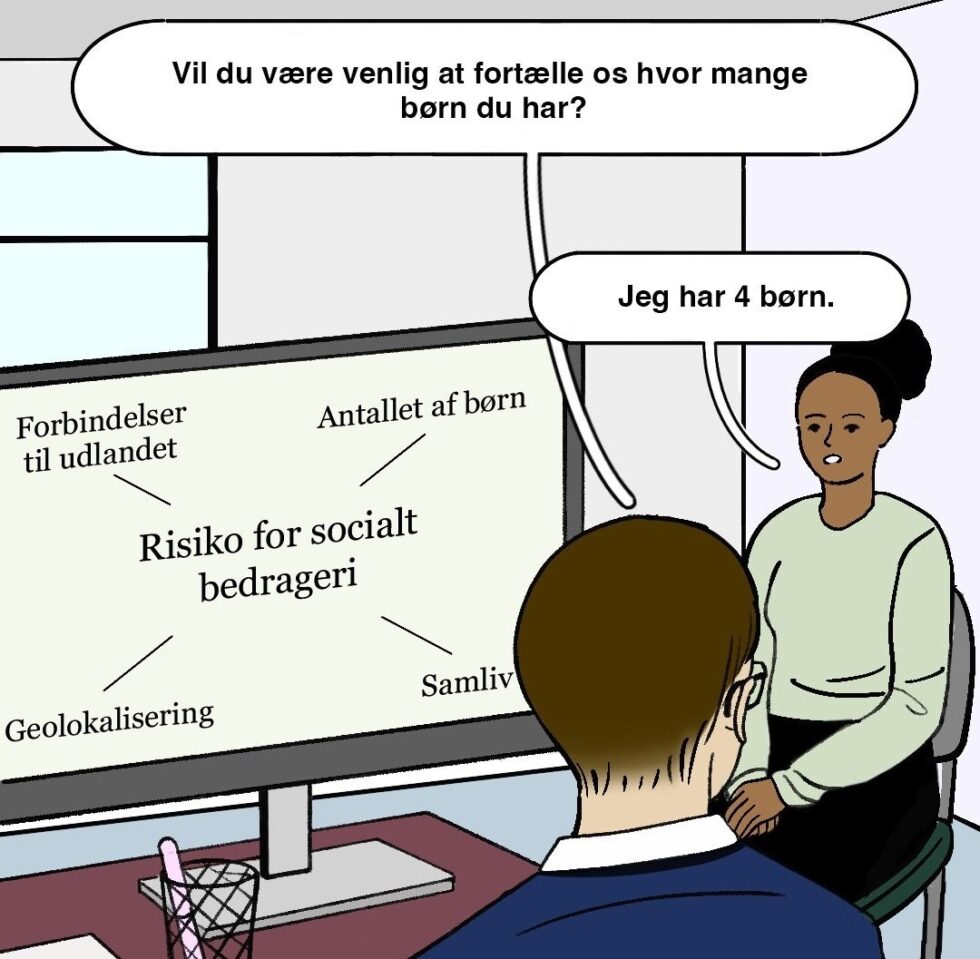

Udbetaling Danmark, som står for udbetaling af en række offentlige ydelser, bruger kunstig intelligens i jagten på social svindel.

I mere end to år har Amnesty International undersøgt Udbetaling Danmarks brug af kunstige intelligens. Det har mundet ud i rapporten “Coded Injustice: Surveillance and Discrimination in Denmark’s Automated Welfare State“.

Rapporten konkluderer, at det danske velfærdssystem angriber de mennesker, som systemet er sat i verden for at hjælpe med 60 forskellige overvågningsalgoritmer.

I realiteten masseovervåger og snager myndighederne i millioner af danske borgeres privatliv.

Det gør man med risiko for, at systemet diskriminerer for eksempel mennesker med handicap, flygtninge og migranter samt andre udsatte grupper i jagten på muligt socialt bedrageri.

Masseovervågning afkoblet fra virkeligheden

Udbetaling Danmark har overladt kontrollen med de sociale ydelser til ATP Koncernen, som har fået hjælp af flere private firmaer, herunder it-virksomheden NNIT, til at udvikle de 60 forskellige algoritmer, som den kunstige intelligens bygger på.

Algoritmerne indsamler store mængder data fra offentlige databaser med millioner af danskere. De skal opdage svindel med sociale ydelser og udpege folk, som myndighederne skal undersøger nærmere. Dataene omfatter oplysninger om opholdsstatus, statsborgerskab, fødested og familieforhold – følsom information, som i sidste ende kan fortælle noget om en persons race, etnicitet eller seksuelle orientering.

”Pistolen peger altid på os”

Personer, som Amnesty International har interviewet, beskriver, hvordan de oplever psykisk belastning ved at blive udsat for overvågning af blandt andet sagsbehandlere. Mennesker med handicap føler sig deprimerede og føler, at den konstante kontrol “æder” dem op, når de konstant bliver afhørt af sagsbehandlere. Som en interviewperson beskriver det: “Det er som at sidde for enden af pistolen. Vi er altid bange. Det er som om, at pistolen peger på os.”

Dd diskriminerende algoritmer

Der er samtidig risiko for diskrimination, fordi algoritmerne bygger på allerede eksisterende uligheder i det danske samfund.

For at opfange mulig svindel med sociale ydelser i for eksempel pensions- og børnepasningsordninger anvender myndighederne en algoritme for, om en person virkelig er single til at forudsige den enkeltes familie- eller forholdsstatus. Er der “usædvanlige” eller “atypiske” levemønstre eller familiearrangementer.

Det betyder at eksempelvis mennesker med handicap, der er gift, men som bor adskilt på grund af deres handicap; ældre mennesker i parforhold, der bor adskilt; eller folk, der bor flere generationer under samme tag, ses ofte i familier af anden etnisk herkomst alle er i fare for at blive udtaget til yderligere efterforskning af algoritmen. Også mennesker med mulig udenlandsk tilhørsforhold kommer i algoritmernes søgelys f.eks. hvis man har bånd til lande uden for de europæiske EØS-lande.

Ifølge Udbetaling Danmark er den omfattende indsamling og sammenlægning af personoplysninger “lovligt begrundet”.

Amnestys research viser dog, at de enorme mængder data, der indsamles og behandles, hverken er nødvendige eller kan forsvares med det udbytte, myndighederne får ved at opdage eventuel svindel.

Ulovligt ifølge EU?

Forskellige internationale menneskerettighedstraktater, EU-love og national lovgivning forpligter Danmark til at sikre privatliv, databeskyttelse, ytringsfrihed, lighed og ikke-forskelsbehandling.

Men systemet, der bruges i jagten på socialt bedrageri, fungerer som et slags scoringssystem, hvilket er ulovligt under den nye EU-lov om kunstig intelligens, ifølge Hellen Mukiri Smith, der er Amnesty Internationals researcher på kunstig intelligens. Hun siger videre:

”De danske myndigheder skal omgående implementere et klart og juridisk bindende forbud mod brug af data relateret til udenlandsk tilhørsforhold. De skal også sikre robust gennemsigtighed og tilstrækkeligt overblik i udviklingen og implementeringen af algoritmerne til svindelkontrol.”

”Den måde, det danske automatiserede velfærdssystem fungerer på, udhuler den enkeltes privatliv og underminerer den menneskelige værdighed. Ved at implementere algoritmer og traditionelle overvågningsmetoder til at identificere svindel med sociale ydelser, muliggør myndighederne en digitaliseret masseovervågning.”

Uddraget her er fra en artikel fra Amnesty International om rapporten. Rapporten udkom den 1. november 2024 og er på 84 sider.

Hele rapporten finder du her: https://amnesty.dk/wp-content/uploads/2024/11/Coded-Injustice-Surveillance-and-discrimination-in-Denmarks-automated-welfare-state.pdf

Tilføj en kommentar